200秒=超算1万年,谷歌量子霸权论文引发全球热议

量子计算机用3分20秒完成的一项计算,全球最强大的超算Summit要花1万年。

这个成果,来自谷歌最新的量子计算研究,发表在NASA官网上。论文宣布,“量子霸权”实现了。

英国政府的量子技术顾问Steve Brierley说:

这是第一次有人证明,量子计算机的性能真的能超过经典计算机。

是个了不起的成就。

另外,美国民主党的总统参选人杨安泽,推特转发了这则,引起强烈关注,一日便有5100人点赞:

大事啊,至少说明,没有什么破解不了的密码了。

虽然,NASA没过多久便下架了这篇论文,但正因如此,人类反而对谷歌新的成果更加好奇了。

一窥论文

NASA匆匆撤下了论文,我们仍然能从网页缓存中一窥论文的内容。

谷歌在论文摘要中说:

我们使用具有53个超导量子位的可编程处理器,占用状态空间为253≈1016。重复实验的测量结果会采样相应的概率分布。

我们使用经典模拟进行验证。虽然我们的处理器大约需要200秒来采样一

百万个量子电路实例,但是一台先进的超级计算机将需要大约1万年的时间来执行等效的任务。

相对于所有已知经典算法而言,这种巨大的提速在实验中实现了计算任务上的量子霸权,并预示了人们期待已久的计算范式的出现。

在摘要中,谷歌揭示了这台量子计算机强大的原因,由于量子力学中物体的状态是在希尔伯特空间中演化,因此只需53个量子位就可以模拟1016种状态,而这个数字已经超出了当今超级计算机的运算能力(一般是等价于50个量子比特)。

主要指出的是谷歌虽然实现了72个量子位的芯片,但这和72位量子计算机是两回事。谷歌Bristlecone芯片是利用9个相同模式的量子比特进行耦合,然后依次扩展出去,并非实现了两两量子比特之间的耦合。

量子计算机的实际应用也面临诸多问题。由于在于0和1两种状态之间的能量差太小,需要降低到绝对零度附近,才能防止被热量所破坏。

此外,粒子之间状态的耦合也有时间限制,时间一长,两个粒子将不再“相干”。在进行量子计算实验时,所有的量子操作要在量子退相干之前完成,才能保证量子操作的保真度(Fidelity),否则运算结果将不再可信。

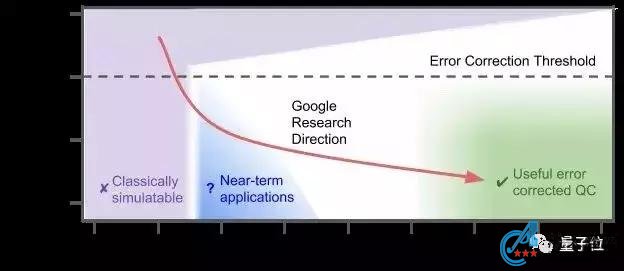

今年3月,谷歌在一篇论文中给出了如下的量子计算机演化概念图:

这张图显示了量子计算错误率和量子比特数之间的关系。谷歌量子人工智能实验室的预期研究方向为图中红色曲线,他们希望通过建立纠错量子计算机,降低错误率,从而将这项技术推入右下角的绿色可用区域。

什么是量子霸权

量子霸权,也叫量子优势,即在未来的某个时刻,功能强大的量子计算机可以完成经典计算机几乎不可能完成的任务。

比如在一天之内破解原本几万年才能破解的密码、实现通用人工智能、快速模拟分子模型。

提出这一假想的原因是,量子计算机的发展似乎遵循着“内文定律”,而经典计算机遵循着“摩尔定律”。

△提出内文定律的Hartmut Neven

摩尔定律为大众所熟知,即计算机芯片的晶体管密度每18个月翻一番,算力增强一倍,这是一种指数增长的规律。但是近年来随着晶体管的尺寸逐渐逼近物理学极限,这一定律已经放缓甚至失效。

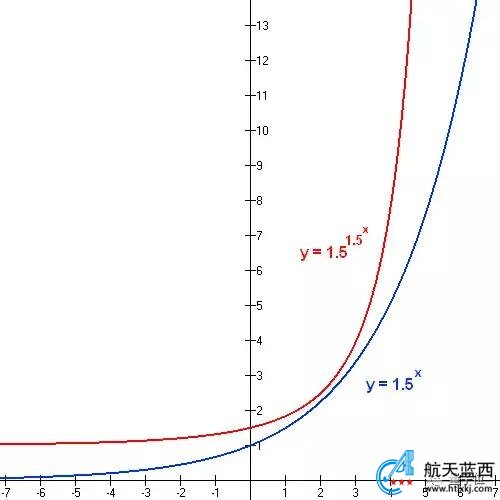

而来自谷歌量子人工智能实验室的负责人Hartmut Neven认为,量子计算机的速度正在以双指数的速度增长。双指数是指数之上再加一层指数,形式如下:

Neven认为,量子计算机比经典计算机存在着两个指数优势:

首先,量子位相比普通位具有效率优势,如果一个量子电路具有4个量子位,那么需要一个具有16个普通位的经典电路才能实现等效的计算能力。

其次,量子芯片也在快速改进。谷歌量子芯片正在以指数级的速度发展,这种快速的改善是由于量子电路中错误率的降低。而降低错误率能帮助我们构建更大的量子芯片。

双指数的增长速度远远快于指数函数,因此谷歌认为虽然量子计算机速度现在远不及经典计算机,但是总有一天会超过后者。

这可不仅仅是谷歌研究人员的自卖自夸,实际上谷歌实验室也是按照双指数规律的速度在推进着:去年12月,一台笔记本电脑即可模拟谷歌最好的量子计算机;到了今年1月,一台功能强大的台式机才可与之媲美;而到了今年2月,经典计算机的速度已经不能和量子计算机匹敌,无法再模拟后者了。

为何由NASA发布

也许你会好奇,谷歌的论文为何要在NASA官网上发布。其实谷歌去年就已经和NASA展开合作,并且立下了flag:要在今年实现所谓量子霸权,即让量子计算机的运算能力远远超过经典计算机。

2018年7月,谷歌宣布与NASA建立合作伙伴关系,计划将量子计算机上运行的结果,与经典仿真进行比较,实现所谓的“量子霸权”,而且当时的谷歌预测在今年就可以实现。

双方合作使用的量子芯片名字叫做Bristlecone,总共包含72个量子比特。由于Bristlecone需要将超导电路维持在绝对零度附近,因此无法将其从谷歌的实验室搬走。NASA研究人员只能通过谷歌的云API远程连接Bristlecone。

双方将共同研究如何将“各种各样的优化和采样问题”映射到Bristlecone量子计算系统上。

按照双方的约定,今年年初,他们在NASA最强的超级计算机Pleiades上对运行这些仿真所必需的软件进行编码,并在合同签订后的12个月,即今年7月,比较量子电路仿真和谷歌量子计算机硬件的结果。

虽然谷歌和NASA持非常乐观的态度,但业界也有人这个flag要倒。

阿里巴巴数据基础设施和搜索技术部门的研究人员发表了一篇论文,认为要实现量子霸权可能需要错误率更低的量子芯片。

南加州大学量子信息科学与技术中心主任Daniel Lidar也对此表示怀疑。他接受麻省理工科技评论时说:“(实现量子霸权)似乎还需要其他方式抑制错误。”

如果这篇论文通过了同行评审,则意味着谷歌和NASA的flag没有倒,而且量子计算将进入一个新的时代。

创造历史

几十年来,量子计算这个领域,都笼罩在一个强大的假设之下:

任何其他类型的计算机,能够高效完成的计算,经典计算机也都能高效完成。

这个假设,来自“广义邱奇-图灵论题” (Extended Church Turing Thesis) 。

如今,谷歌的量子计算机用3分20秒完成的计算,交给全球排名第一的超级计算机Summit,大概需要1万年。这就打破了人类曾经的猜想。

谷歌说:

这标志了第一个只能用量子处理器执行的运算。

在通往全面量子计算的路上,这是一个里程碑。

量子机器的算力,将会以双指数速度增长。

当然,这项前所未有的成就,不止是谷歌自家的狂欢。

为英国政府担任量子技术顾问的Steve Brierley,已经在领域里工作了20年,还是量子软件初创公司Riverlane的创始人。他强调说:

第一次有人证明,量子计算机的性能真的能超过经典计算机。

这是个了不起的成就。

走到领域之外,美国民主党的总统参选人杨安泽 (Andrew Yang) ,是这样说的:

谷歌达成量子霸权是个大事。先不说别的,这至少意味着,没有不能破解的代码了。

他的这条推特,已经收获了5100赞。

不久之后,杨还补充了一条:

我们的加密技术也得跟上啊。

这条推特,又获得了3200赞。

下一步呢

量子霸权实现了,但故事并没有结束。

在许多人的眼里,量子霸权是一个人为设定的里程碑:只要在任何一项任务上,证明量子计算机超过经典计算机就可以了。

怎样的任务都可以,也就不一定有现实意义。比如,谷歌给量子计算机的任务是:鉴定一个随机数生成器,是不是真的随机。

所以,一个里程碑之后,还有另一个里程碑要赶去。

实用性

IBM的量子计算战略负责人Robert Sutor,提到了一个“量子优势(Quantum Advantage) ”概念,那是一个实用性的里程碑:

量子优势,是在一个真实应用场景 (比如金融服务、AI、化学里面) ,量子计算机做出了比任何经典计算机要明显优秀的工作。

作为谷歌的对手,IBM一直在探索量子计算的应用,与摩根大通、梅赛德斯奔驰都有这一方面的合作。最近他们还在线上对外开放了一台53比特的通用量子计算机。

IBM说,量子霸权这个词他们并不用,也不在意。

不过,谷歌研究院、加州理工学院的理论物理学家Fernando Brando相信:

在达成量子霸权之前,量子计算机不可能做出什么有意思的事。

现在,就算量子计算机做的任务还没有实际意义,研究人员还是可以从中学到经验,今后开发出更有用的量子计算机。

2018年,波士顿咨询公司 (BCG) 发布的报告说,量子计算机可以改变许多领域的游戏规则:

比如密码学和化学,对化学的影响会广泛波及材料学,以及农业和制药等等领域。

人工智能,机器学习就更不用说了。

另外,物流,制造,金融,能源……也都会出现新的应用。

这个未来,整个世界都在期待着。

容错率

再下一个里程碑,就是造出一台容错的量子计算机。

这样的计算机,能在一项计算当中实时纠正错误,原则上可以实现无错的量子计算。

目前,主流的方法叫做“Surface Code”,每个执行计算的“逻辑”量子比特,都要有成千上万个纠错量子比特来支持。

这远远超出了当前量子计算的最强算力。

所以,量子计算到底需不需要容错能力,也是值得讨论的问题。

来自谷歌的Fernando Brando说:

有许多思路可走,但没有哪个方向是确定的。

One More Thing

不过,在走向未来之前,关于这项研究,还有一个直击灵魂的问题:

如果说,超算要1万年才能算好,怎么才能知道量子计算机得出的结果是对的呢?